(Vibizmedia-Kolom) Di tengah gelombang kekhawatiran dan sensasi soal superintelligent AI—kecerdasan buatan yang konon akan melebihi manusia dan mungkin mengambil alih dunia—sebuah suara berbeda datang dari para peneliti AI itu sendiri. Mereka menyatakan bahwa AI hari ini, terlepas dari semua kemampuannya menulis esai, menjawab pertanyaan, atau meniru ucapan manusia, masih belum mendekati apa yang disebut akal sehat atau penalaran sejati.

Argumen ini tidak datang dari suara kecil di pinggiran riset, melainkan dari para ilmuwan yang telah bertahun-tahun berada di pusat pengembangan teknologi ini. Mereka menilai bahwa klaim tentang kebangkitan AGI (Artificial General Intelligence) hanya dalam beberapa tahun ke depan, seperti yang sering disampaikan oleh Sam Altman dari OpenAI atau Dario Amodei dari Anthropic, terlalu berlebihan dan tidak sejalan dengan bukti empiris.

Salah satu laporan paling tajam datang dari tim riset Apple, yang menulis makalah berjudul The Illusion of Thinking. Dalam dokumen ini, mereka menunjukkan bahwa model AI terkini gagal total ketika menghadapi tugas-tugas penalaran abstrak, seperti pemecahan logika berlapis, permainan urutan, atau teka-teki dasar seperti Tower of Hanoi. Bahkan, model seperti ChatGPT yang telah dilatih dengan miliaran parameter dan data dari seluruh web sering terhenti di titik-titik yang justru bisa diselesaikan oleh anak sekolah dasar.

Kegagalan ini disebut sebagai accuracy collapse – kemampuan model terlihat mengesankan pada awalnya, tetapi semakin kompleks soal yang diberikan, semakin tinggi kemungkinan model menjawab keliru—tanpa menyadari bahwa jawabannya salah. Ini bukan hanya soal ketidaktahuan, tapi soal ketiadaan struktur logika internal yang stabil.

Para peneliti menyebut masalah ini sebagai fragilitas heuristik. Artinya, sistem AI bekerja berdasarkan pola dan asosiasi, bukan pemahaman kausalitas atau narasi internal seperti yang terjadi dalam akal manusia. Ketika teks yang dilatih mendukung satu jawaban, model akan percaya diri—meskipun jawabannya keliru secara logika.

Profesor Gary Marcus, salah satu pengkritik keras hype AI, menyebut LLM (Large Language Models) sebagai mesin asosiasi statistik yang sangat meyakinkan, tapi tetap dangkal. Mereka dapat meniru struktur jawaban, tetapi tidak mengerti konteks, tidak punya intuisi, dan tidak membangun model mental.

Yann LeCun, Chief AI Scientist dari Meta, menegaskan bahwa AI saat ini masih jauh dari level dog-level intelligence, apalagi manusia. Menurutnya, untuk bisa menyamakan diri dengan manusia, AI tidak hanya harus tahu apa itu meja, tetapi juga mengerti mengapa meja digunakan, bagaimana meja berinteraksi dengan objek lain, dan kapan penggunaan meja dianggap wajar. Model sekarang tidak punya kemampuan itu.

Di sisi lain, perusahaan AI besar seperti OpenAI, Google DeepMind, dan Anthropic tetap berpegang pada narasi bahwa AGI akan hadir dalam dua hingga lima tahun, dan mereka sedang berlomba untuk mengendalikannya agar tidak berbahaya. Tapi semakin banyak ilmuwan yang melihat retorika ini sebagai cara untuk menggalang pendanaan, mengatur regulasi yang menguntungkan, dan mempertahankan dominasi pasar.

Kenyataannya, sebagian besar perkembangan AI saat ini berada dalam batas-batas yang telah dikenal sejak satu dekade lalu. Model-model menjadi lebih besar, lebih cepat, dan lebih berbicara seperti manusia—tetapi tidak menjadi lebih bijak, cerdas, atau kritis. Bahkan kemampuan multitugas yang dulu dijanjikan banyak AI—misalnya menyusun rencana, berpikir strategis, atau memahami konsekuensi etis—masih bergantung pada input manusia.

Hal ini memunculkan pertanyaan – apakah pendekatan yang kini mendominasi, yaitu scaling laws atau memperbesar model dan data, benar-benar akan membawa kita ke AGI? Ataukah kita sedang menempuh jalan buntu yang mahal dan tidak membawa terobosan konseptual?

Banyak peneliti mulai mengajukan pendekatan baru—menggabungkan symbolic reasoning, pembelajaran kausal, dan arsitektur multi-modular—untuk mendekati kecerdasan yang lebih mirip manusia. Tetapi pendekatan ini belum dominan di pasar, karena perusahaan besar lebih tertarik mengejar profit instan dari model chatbot dan layanan AI generatif.

Sementara itu, kecemasan publik terus dikobarkan. Banyak pihak takut AI akan mengambil alih dunia kerja, menyebar disinformasi massal, bahkan merancang sistem senjata otonom. Ketakutan ini valid, tetapi sering kali bercampur dengan ketidaktahuan tentang batas nyata teknologi saat ini.

Untuk sementara, AI adalah alat—sangat kuat dalam beberapa hal, tetapi masih sangat lemah dalam aspek lainnya. Memahami batas ini penting agar masyarakat tidak terperangkap antara euforia palsu dan paranoia tak berdasar.

Dunia riset masih punya jalan panjang. Para insinyur perlu merancang sistem yang tidak hanya menjawab apa, tetapi juga mengerti mengapa dan bagaimana. Pemerintah dan masyarakat harus mendorong pendekatan yang lebih aman, lebih transparan, dan lebih pluralistik. Dan media perlu berhenti mengulang-ulang narasi robot akan mengambil alih dunia setiap kali ada demo AI baru.

Jika melihat sejarah pengembangan AI, siklus antusiasme dan kekecewaan ini bukan hal baru. Sejak dekade 1950-an, ketika para pionir seperti Alan Turing dan Marvin Minsky mulai merancang program komputasi yang bisa “berpikir”, komunitas riset telah berkali-kali mengalami hype berlebihan. Pada 1970-an dan 1980-an, proyek ambisius seperti expert systems dan robotika cerdas sempat menjanjikan lompatan besar, tapi akhirnya stagnan karena keterbatasan komputasi dan pemahaman.

Kini, dengan kekuatan pemrosesan dan data masif, kita memasuki gelombang optimisme baru. Namun pertanyaan dasarnya tetap sama: apakah kita hanya membangun sistem yang lebih besar dan cepat, ataukah benar-benar lebih cerdas dan bijak? Ukuran parameter bukan jaminan kecerdasan sejati.

Di banyak laboratorium, peneliti mulai menyadari bahwa meniru perilaku manusia secara statistik bukanlah cara terbaik memahami pikiran manusia. Dibutuhkan sistem yang bisa membuat representasi internal, mempertimbangkan niat, memahami makna sosial, dan memperhitungkan konsekuensi moral. Ini adalah wilayah yang tidak bisa dicapai hanya dengan menambahkan data atau komputasi.

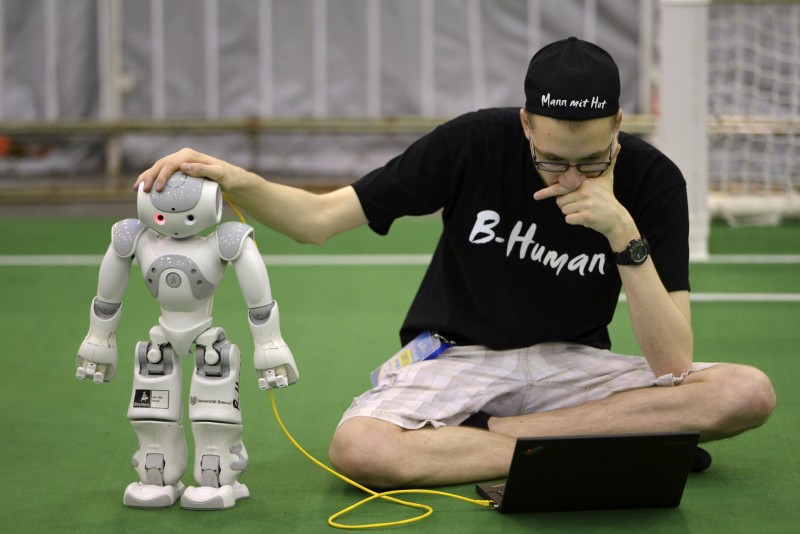

Penting pula menyadari bahwa kecerdasan tidak bisa dilepaskan dari konteks tubuh, dunia nyata, dan interaksi sosial. Itulah sebabnya banyak proyek robotik kini kembali mengeksplorasi embodied AI—yakni AI yang belajar melalui interaksi fisik, bukan hanya teks.

Di tengah semua perdebatan itu, kita perlu lebih banyak mendengar suara dari luar pusat kekuatan teknologi global. Negara-negara berkembang seperti Indonesia, India, atau Brasil, punya kebutuhan dan konteks sosial yang berbeda. AI yang dikembangkan untuk mereka haruslah inklusif, transparan, dan sadar konteks lokal.

Misalnya, AI yang digunakan untuk pendidikan di desa-desa terpencil harus bisa menjelaskan konsep dalam bahasa lokal dan dengan contoh konkret. AI untuk layanan publik harus menghindari bias sosial yang memperkuat diskriminasi. Jika tidak, teknologi akan menjadi alat dominasi baru, bukan alat pembebasan.

Masa depan AI tidak hanya tergantung pada penemuan teknis, tetapi juga pada keputusan politik, etika, dan ekonomi yang kita ambil hari ini. Regulasi yang melindungi publik, kebijakan yang mendorong keterbukaan, dan pendidikan yang membekali warga dengan literasi digital akan menentukan arah perkembangan AI.

Superintelligent AI mungkin masih jauh, tapi dampak AI hari ini sudah nyata. Daripada menunggu “mesin superpintar” datang, lebih baik kita fokus membentuk sistem yang saat ini sudah memengaruhi hidup kita. Karena dari situlah masa depan kecerdasan buatan sesungguhnya dimulai.